Key Message

- AI ทำงานบนพื้นฐานของการคาดเดาความน่าจะเป็นของคำตอบที่น่าจะเป็นไปได้มากที่สุด แต่ไม่ได้ทำความเข้าใจด้วยตรรกะเช่นเดียวกับมนุษย์

- AI อาจเกิดอาการ Hallucinate เพราะถูกสอนให้ตอบอย่างมั่นใจ แทนที่จะตอบว่าไม่รู้

- ปัจจุบันบริษัทระดับโลกยังต้องใช้งบประมาณในการลงทุนอย่างมหาศาลเพื่อการพัฒนาความสามารถของ AI อย่างต่อเนื่อง

- หากให้ AI ช่วยเขียนโค้ด มันจะสร้างโค้ดจากสิ่งที่น่าจะเป็นไปได้มากที่สุดตามที่ได้รับการฝึกฝนมา แต่ไม่ใช่โค้ดที่ถูกต้อง หรือปลอดภัยที่สุด

- คุณภาพของข้อมูลที่ใช้ฝึกฝน AI ในปัจจุบันยังไม่สูงพอ ยิ่งโดยเฉพาะในมุม Cybersecurity ที่มีการเปลี่ยนแปลงอย่างรวดเร็วของภัยคุกคาม และช่องโหว่

- เมื่อองค์กรต่าง ๆ เชื่อ AI มากเกินไป เราอาจมี "Lost Generation of Engineers" ซึ่งขาด Engineers ที่รู้วิธีแก้ปัญหาช่องโหว่ หรือเขียนโค้ดที่ปลอดภัยอย่างแท้จริงตั้งแต่เริ่มต้นไป

- AI เป็นเทคโนโลยีที่มีประโยชน์ แต่ในปัจจุบัน ผู้ใช้งาน และองค์กรต่าง ๆ ควรตระหนักถึงความเสี่ยงจากความถูกต้องของข้อมูล และไม่ควรเชื่อถือ AI มากเกินไปโดยไม่มีการตรวจสอบข้อมูลซ้ำอีกครั้ง

ในยุคปัจจุบัน AI ถูกพูดถึงมากขึ้นอย่างแพร่หลาย ทั้งจากการรายงานข่าวทางโทรทัศน์, ทาง Social Media หรือแม้แต่จากผู้คนทั่ว ๆ ไป ที่ก็นำ AI มาใช้งานในชีวิตประจำวันในรูปแบบต่าง ๆ และทำให้กลายเป็นมาตรฐานในวงการ Tech ที่บริษัทระดับโลกต่างก็ต้องมีการนำ AI มาใช้ ไม่ทางใดก็ทางหนึ่ง หรือบางรายก็เป็นเจ้าของ AI ซะเอง จึงเป็นสาเหตุให้ผลิตภัณฑ์ทางด้าน Technology ในปัจจุบัน ต้องโฆษณาว่ามีการนำ Technology AI มาใช้ใน Product หรือบริการ หรือนำมาใช้ทดแทน ’มนุษย์’ ในการทำงานได้ เพราะหากไม่เป็นเช่นนั้น อาจไม่ถูกพิจารณา หรือถูกมองว่าล้าสมัยไปเลยด้วยซ้ำ

แต่เทคโนโลยีนี้ต้องใช้งบประมาณลงทุนมหาศาล ยกตัวอย่างเช่น

- Meta ยอมลงทุนกว่า $100M เพื่อดึงตัวผู้เชี่ยวชาญทางด้าน AI จากบริษัทอื่น ๆ

- OpenAI ที่ก็ลงทุนไปก่อนหน้านี้จำนวนมากกับ ChatGPT

- Google ก็ลงทุนไปกับการพัฒนา Gemini ไปอย่างน้อยมากกว่า $192M

ซึ่งแสดงให้เห็นว่าบริษัทเหล่านี้ยังคงมองว่า Technology AI ในปัจจุบัน ยังจำเป็นต้องได้รับการพัฒนาอย่างต่อเนื่อง จึงเกิดคำถามว่า เราจะเชื่อมั่นได้อย่างไรว่า Technology AI อื่น ๆ ที่อ้างว่าสามารถนำมาใช้ทดแทนการทำงานของ ‘มนุษย์’ ได้ แต่อาจพัฒนาด้วยงบประมาณที่จำกัด จะสามารถทำงานได้อย่างถูกต้อง และมีประสิทธิภาพจริง

ทำไมจึงเป็นเช่นนั้น?

AI ในปัจจุบันส่วนใหญ่ทำงานบนพื้นฐานของการคาดเดาความน่าจะเป็นของคำตอบที่น่าจะเป็นไปได้มากที่สุด โดยเรียนรู้จากข้อมูล และข้อความจำนวนมหาศาลเพื่อทำความเข้าใจรูปแบบ แต่ AI ไม่ได้ทำความเข้าใจด้วยตรรกะเช่นเดียวกับมนุษย์ (แม้จะดูเหมือนว่าทำได้ก็ตาม) ดังนั้น AI จึงมักตอบอะไรบางอย่างที่ดูแล้วสมเหตุสมผลด้วยความมั่นใจ แม้ว่าข้อมูลนั้นอาจจะผิดทั้งหมดก็ได้

มีคลิปวิดีโอหนึ่งบน Youtube ของช่อง “Logically Answered” ที่พูดถึงความผิดพลาดของ AI โดยยกตัวอย่างจาก Vibe Coding (การพัฒนาซอฟต์แวร์โดยใช้ AI เพื่อสร้างโค้ด) ได้อย่างน่าสนใจ

Youtube : https://www.youtube.com/watch?v=vHPpBZiR80c

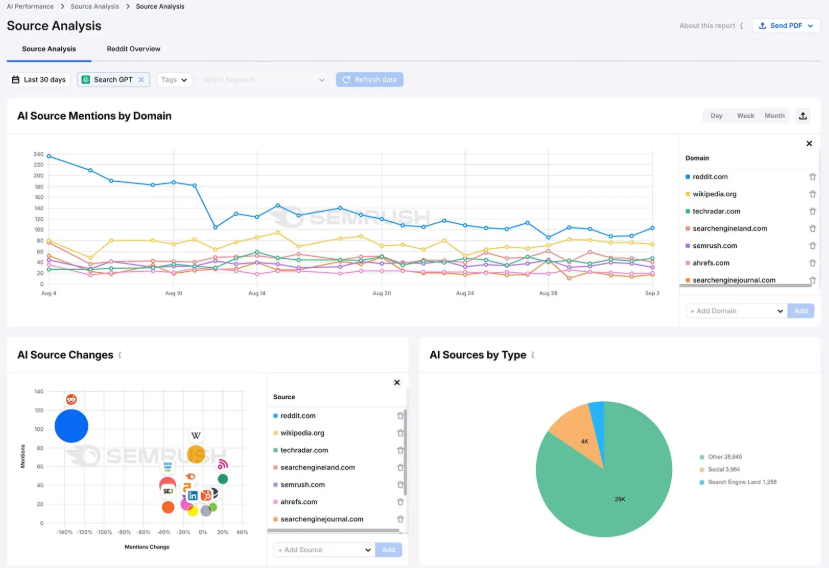

ตัวอย่างเช่น ในช่วงนาทีที่ 03:42 ปัจจุบัน AI สามารถ Search ข้อมูลบนเว็บได้ แต่ปรากฏว่าแหล่งที่มาที่ ChatGPT ใช้ค้นหามากที่สุดคือ reddit

อ้างอิงจาก : https://www.semrush.com/blog/ai-search-visibility-study-findings/

แม้ reddit จะเป็น Community ที่มีผู้เชี่ยวชาญจำนวนมาก แต่ก็เต็มไปด้วยความคิดเห็นส่วนตัว (Opinion) สิ่งที่ AI เรียนรู้เพื่อมาตอบเราจึงอาจไม่ใช่ข้อเท็จจริง (Fact) ทั้งหมด หากนำไปใช้โดยไม่ตรวจสอบ อาจทำให้สร้างความเข้าใจผิดได้

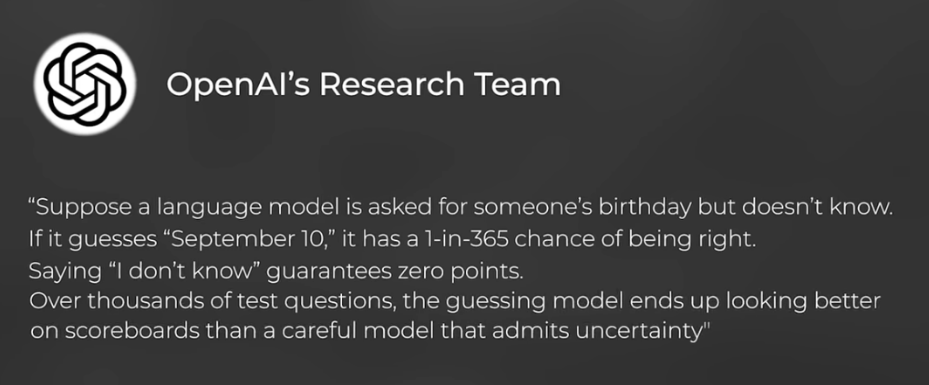

อีกประเด็นที่น่าสนใจนาทีที่ 04:26 AI อาจเกิดอาการ Hallucinate เพราะมันมักถูกสอนให้ตอบอย่างมั่นใจ แทนที่จะตอบว่า "ฉันไม่รู้" เช่น ถ้าถูกถามถึงวันเกิดที่ AI ไม่รู้ การเดา (เช่น "10 กันยายน") มีโอกาสถูก 1 ใน 365 แต่การตอบว่า "ฉันไม่รู้" จะการันตีว่าได้คะแนนเป็นศูนย์ ความมั่นใจนี้อาจหลอกให้มนุษย์เชื่อในสิ่งที่ AI ไม่รู้จริง

อ้างอิงจาก https://openai.com/index/why-language-models-hallucinate/

เมื่อ 'โค้ดที่ใช้ได้' อาจไม่ปลอดภัย

จากตัวอย่างข้างต้น หากเราสั่งให้ AI เขียนโค้ด มันก็จะสร้างโค้ดจากสิ่งที่น่าจะเป็นไปได้มากที่สุดตามที่ได้รับการฝึกฝนมา ซึ่งอาจจะไม่ใช่โค้ดที่ถูกต้อง หรือปลอดภัยที่สุด เพราะ AI ไม่ได้เข้าใจจริง ๆ ว่าโค้ดที่ดี ที่ถูกต้อง และปลอดภัยที่สุดต้องเป็นอย่างไร และมักจะได้รับการฝึกฝนจากโค้ดที่เปิดให้เข้าถึงแบบสาธารณะ ซึ่งส่วนใหญ่แล้วมักจะไม่สามารถใช้งานได้จริง หรือใช้งานได้ แต่มี Bug หรือช่องโหว่จำนวนมาก และไม่ได้คำนึงถึงความปลอดภัยเป็นอันดับแรก

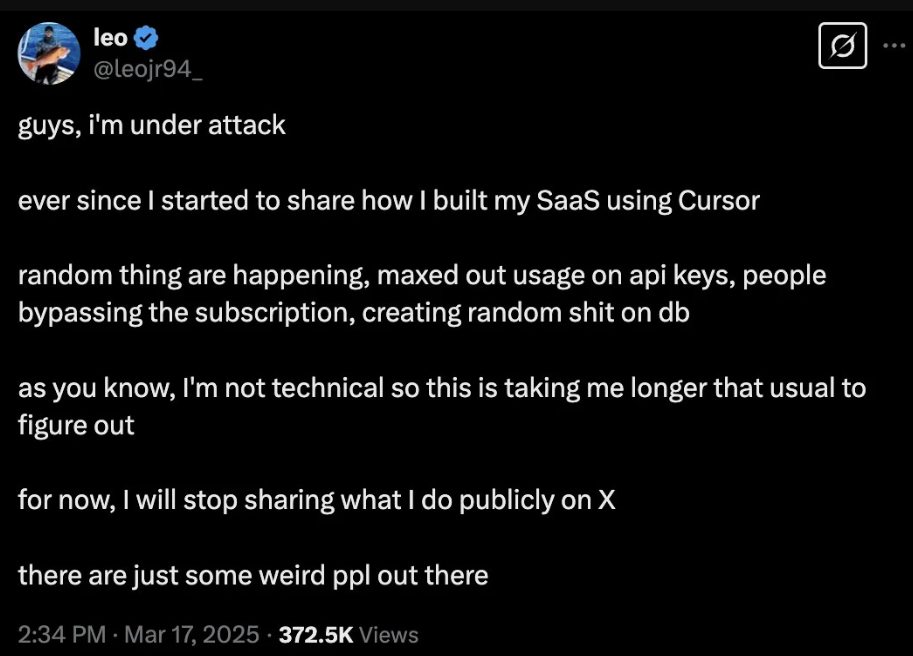

ตัวอย่างเช่นในนาทีที่ 05:48 นักพัฒนาท่านหนึ่งซึ่งใช้ Cursor AI เพื่อสร้างโค้ดสำหรับ SaaS Business ของเค้าทั้งหมด กลับพบว่าโค้ดที่ถูกเขียนด้วย AI มีการทิ้ง API Keys แบบ Hard-coded ทำให้ผู้คนสามารถนำ API มาใช้ฟรีจนเต็มขีดจำกัด, Bypass Subscription หรือเปลี่ยนแปลงข้อมูลบน Database ได้

อ้างอิงจาก : https://x.com/leojr94_

เหตุการณ์ Vibe Coding ลักษณะนี้ยังคงเกิดขึ้นจำนวนมาก อาจเพราะคุณภาพของโค้ดที่ใช้ฝึกฝน AI ยังไม่สูงพอ โดยเฉพาะในมุม Cybersecurity ที่ข้อมูลที่จะนำไปใช้ฝึกฝน AI อาจมีน้อยกว่า เนื่องจากการเปลี่ยนแปลงอย่างรวดเร็วของภัยคุกคาม และช่องโหว่ การฝึก AI ให้เข้าใจการโจมตีอย่างครอบคลุมจึงเป็นความท้าทายอย่างมากสำหรับนักพัฒนา AI

สิ่งที่น่ากังวลมากขึ้นคือ องค์กรต่าง ๆ มักเชื่อถือ AI มากเกินไป โดยอาจถูกโฆษณาว่าควรใช้ AI แทนที่คนทำงานระดับ Junior หากคนเหล่านี้ซึ่งจะพัฒนาไปเป็น Senior หายไป ในอนาคตเราอาจมี "Lost Generation of Engineers" ซึ่งขาด Engineers ที่รู้วิธีแก้ปัญหาช่องโหว่ หรือเขียนโค้ดที่ปลอดภัยอย่างแท้จริงตั้งแต่เริ่มต้นไป

จากตัวอย่างทั้งหมดอาจสรุปได้ว่า แม้ AI จะเป็นเทคโนโลยีที่มีประโยชน์ และการลงทุนมหาศาลจากบริษัทระดับโลกอาจช่วยให้มันก้าวข้ามขีดจำกัดในปัจจุบันได้ แต่ในปัจจุบัน ผู้ใช้งาน และองค์กรต่าง ๆ ควรตระหนักถึงข้อจำกัด และความเสี่ยงของ AI และไม่ควรเชื่อถือ AI มากเกินไปโดยไม่มีการตรวจสอบข้อมูลซ้ำ เพื่อป้องกันปัญหาด้านความถูกต้อง และความปลอดภัย ซึ่งอาจสร้างผลกระทบกับองค์กรได้มากกว่าการลดค่าใช้จ่ายโดยการนำ AI มาใช้งานแทนมนุษย์

You must be logged in to post a comment.